Identifiziere SEO-Fehler mit der Google Search Console

Keine Artikel mehr verpassen? Jetzt Newsletter abonnieren »

Level: Beginner

Mit der Google Search Console (GSC) kannst du die Performance deiner Website in den Google Suchergebnissen überwachen und analysieren. Außerdem hilft sie dir, Fehler auf deiner Website zu erkennen, die möglicherweise schwer wiegen und dazu führen können, dass deine Website nicht mehr ansteuerbar ist. Wir wollen dir heute typische Probleme erklären, die du mit der GSC identifizieren und teilweise auch beheben kannst. Als Grundlage dient uns dieser Artikel von SEMrush.

Inhalt

- Fehler in der Google Search Console verstehen

- Fehler in der Google Search Console finden und beheben

- Wie kannst du Fehler von vornherein verhindern?

Die Google Search Console ist ein kostenfreies Google-Tool, das jeder verwenden kann, der eine Website betreibt. Bevor du loslegen kannst, musst du deine Website für die GSC verifizieren. Eine Anleitung dazu findest du direkt bei Google. Falls deine Website bereits für die GSC registriert ist, du aber keinen Zugang hast, musst du diesen beim zuständigen Webmaster in deinem Unternehmen anfragen.

Fehler in der Google Search Console verstehen

Stößt der Googlebot beim Crawlen deiner Website auf ein Problem, wird dieses in der Google Search Console angezeigt. Für dich ist es wichtig, diese Probleme regelmäßig zu überprüfen. Es kann sein, dass ein Problem gemeldet wird, das eigentlich gar kein Fehler, sondern von dir so gewollt ist. In einigen Fällen handelt es sich aber um wirkliche Probleme. Dann solltest du handeln. Es gibt einige Fehler, die gravierende Folgen haben können und z. B. dafür sorgen, dass dein Ranking sich verschlechtert. Oder noch schlimmer: dass User:innen deine Seite gar nicht (mehr) bei Google finden können.

Außerdem bekommst du Informationen zur Benutzerfreundlichkeit deiner Seite. Auch hier solltest du Probleme ernst nehmen und angehen, da eine schlechte Nutzererfahrung sich ebenfalls negativ auf dein Ranking auswirkt.

Fehler in der Google Search Console – wie finde ich sie und wie kann ich sie beheben?

Statuscode-Fehler

In der Google Search Console erhältst du Auskunft über die HTTP-Statuscodes deiner Seiten. Jedes Mal, wenn ein:e User:in oder ein Bot deine Seite aufrufen will, schickt der Server einen Statuscode zurück, der dem Browser bzw. dem Bot Informationen über deine Seite weitergibt.

Der Statuscode „200“ heißt so viel wie „alles in bester Ordnung“. Wenn deine Seite diesen Code zurückgibt, funktioniert erstmal alles und Nutzer:innen sowie Bots können auf die Seite zugreifen und sie ansehen.

Daneben gibt es aber weitere Statuscodes, die auf Probleme hindeuten können.

HTTP-Statuscodes werden jedes Mal weitergegeben, wenn eine Website geladen wird. Wenn ein Nutzer eine URL eingibt oder ein Bot die Website besucht, wird eine Anfrage an den Server der Website gesendet. Der Server antwortet mit einem HTTP-Statuscode, der dem Browser oder dem Bot mehr über diese Seite verrät.

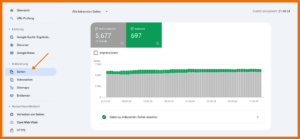

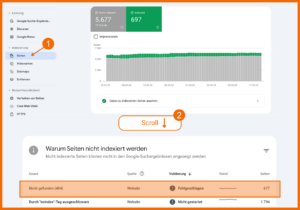

Im Reiter Seiten findest du zunächst Informationen darüber, welche Seiten indexiert sind und welche nicht.

Google Search Console – Statuscode überprüfen

Anschließend findest du unter Grund auch Informationen darüber, ob ein Statuscode dafür verantwortlich ist, dass eine Seite nicht indexiert wurde.

Google Search Console – typische Statuscode-Probleme

In dieser Tabelle können folgende Statuscodes der Grund sein, wieso eine Seite nicht indexiert wurde. Diese solltest du auf jeden Fall überprüfen:

- 5xx: Serverfehler

- 404: Seite nicht gefunden

- 401: Nicht autorisierte Anfrage

- Soft 404

- 3xx: Informationen zu Weiterleitungen

Im Folgenden sehen wir uns an, was die Codes konkret bedeuten und wie du Fehler beheben kannst.

5xx: Serverfehler

Ein dreistelliger Code, der mit „5“ beginnt, steht für einen Serverfehler. Hier gibt es also ein Problem mit dem Server, der deine Website hostet.

Häufige Ursachen für einen 5xx-Status sind:

- Programmierfehler: Bugs oder Kodierungsfehler in den serverseitigen Skripten (z. B. PHP, Python, Ruby), die deine Website betreiben

- Fehler bei Serverkonfiguration: Falsche Konfigurationen in den Servereinstellungen oder der Webserver-Software (z. B. Apache, Nginx)

- Fehlende Ressourcen: Dem Server gehen die Ressourcen aus (z. B. Arbeitsspeicher oder Verarbeitungsleistung)

- Probleme mit der Datenbank: Fehlerhafte Verbindung zur Datenbank oder zum Datenbankserver, auf die sich Ihre Website stützt

So behebst du Serverfehler (5xx):

- Überprüfe die letzten Änderungen, die du an der Website vorgenommen hast Tritt der Fehler erst seit kurzer Zeit auf, solltest du die letzten Änderungen wieder rückgängig machen, um zu sehen, ob das Problem weiter besteht oder nicht.

- Stelle sicher, dass deinem Server genügend Ressourcen zur Verfügung stehen (CPU, Speicher, Festplattenplatz), um die Anfragen an deine Website zu bewältigen. Im Zweifel musst du ein Upgrade bei deinem Hosting-Anbieter in Erwägung ziehen. Ziehe gegebenenfalls ein Upgrade deines Hosting-Angebots in Betracht.

- Wende dich an deinen Hosting-Anbieter, wenn du mit einem Serverproblem nicht weiterkommst. Möglicherweise kann er das Problem identifizieren und beheben.

Sobald du das Problem behoben hast, solltest du eine erneute Abfrage der Seite über die Google Search Console starten, um zu überprüfen, ob alles geklappt hat.

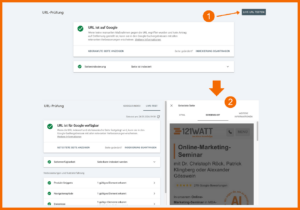

Dazu gibst du die entsprechende URL in das Suchfeld am oberen Rand der Google Search Console ein, drückst „Enter“ auf deiner Tastatur und wählst anschließend „INDEXIERUNG BEANTRAGEN“.

Google Search Console – Indexierung einer URL beantragen

Dieser Vorgang führt dazu, dass der Googlebot die Seite erneut crawlt und sie anschließend – sofern das Problem behoben wurde – ganz regulär in den Index aufnimmt. Aber Geduld: Es kann gerne mal ein paar Tage dauern, bis der Bot deine Seite erneut besucht hat.

404-Fehler: Seite nicht gefunden

Dem 404-Fehler bist du zumindest als User:in sicher schon mal über den Weg gelaufen. Wird der 404-Code zurückgegeben, bedeutet dies, dass die angeforderte URL nicht zu finden ist. Wenn dieser Fehler in der GSC auftaucht, bedeutet es, dass der Googlebot die Seite nicht finden und sie folglich auch nicht indexieren kann. Der 404-Statuscode deutet in der Regel auf einen Fehler hin, dem du nachgehen solltest. Du willst so wenig 404-Fehler wie möglich auf deiner Seite haben.

Häufige Gründe für 404-Fehler:

- Die Seite wurde gelöscht: Wenn du eine Seite absichtlich gelöscht hast und der Bot versucht, diese zu crawlen, wird ein 404-Fehler ausgegeben.

- URL-Änderung: Wenn du die URL einer Seite geändert hast, ohne von der alten auf die neue Seite weiterzuleiten, sieht es für den Bot wie eine neue Seite aus. Die alte URL führt dann ins Nichts und wird als 404-Fehler eingestuft.

- Tippfehler: Wenn dem Googlebot beispielsweise über die Sitemap oder eine interne Verlinkung eine URL mit Tippfehler übermittelt wird, kann er die richtige Seite nicht ansteuern und gibt stattdessen für die Seite mit Tippfehler einen 404-Fehler aus.

So findest du 404-Fehler in der Google Search Console

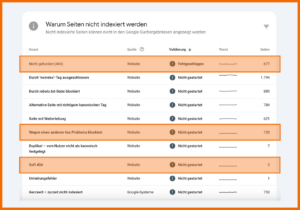

Wie oben bereits beschrieben, klickst du zunächst auf Seiten. Wenn du dann runter scrollst, siehst du den Bericht „Warum Seiten nicht indexiert werden“.

Google Search Console – 404-Fehler identifizieren

Hier musst du nach dem Grund „Nicht gefunden 404“ Ausschau halten. In der letzten Spalte siehst du, wie viele Seiten von diesem Fehler betroffen sind. Klickst du auf die Zeile, öffnet sich eine neue Übersicht, in der du jede einzelne URL findest, die zu einem 404-Fehler geführt hat. Nun kannst du dich an die Arbeit machen und die einzelnen Fehler beheben.

So behebst du 404-Fehler:

- Weiterleitung einrichten: Wenn du die URL einer Seite absichtlich verändert hast, solltest du eine 301-Weiterleitung von der alten auf die neue URL einrichten. Versucht jemand, die alte URL aufzurufen, wird er direkt auf die neue weitergeleitet.

- Interne Links aktualisieren: Wenn es innerhalb deiner Seite Links zu gelöschten Seiten gibt, solltest du diese Links aktualisieren bzw. durch einen gültigen Link ersetzen. Informationen zu ausgehenden Links kannst du mit Hilfe des ScreamingFrog finden.

- Externe Links überprüfen: Wenn andere Websites auf ungültige Links deiner Website verlinken, solltest du handeln. Wende dich an den Betreiber oder die Betreiberin der Seite und bitte darum, den Link auszutauschen.

- Sitemap einreichen: Eine Sitemap ist eine vollständige und strukturierte Auflistung aller URLs deiner Website. Sie erleichtert Google das Crawlen und Indexieren deiner Seite. Halte deine Sitemap stets aktuell. Falls du noch keine hast, kannst du sie in der Google Search Console unter Indexierung > Sitemaps einreichen.

401-Fehler: nicht-autorisierte Anfrage

Ein Fehler mit dem Statuscode „401“ in der Google Search Console bedeutet, dass eine Anfrage „nicht autorisiert“ war. Der Browser verweigert den Zugriff auf eine Seite.

Häufige Gründe für 401-Fehler:

- Passwortgeschützte Inhalte: Wenn sich Inhalte hinter einem Passwort verbergen, können der Googlebot und andere Crawler nicht darauf zugreifen.

- Zugriffsbeschränkungen: Wenn die IP-Adressen des Googlebots für eine Seite blockiert wurden, kann er nicht mehr darauf zugreifen. Es wird ein 401-Fehler gemeldet.

- Konfigurationsprobleme: Wenn versehentlich Fehler bei der Konfiguration der Website für Crawler gemacht wurden, wird der 401-Fehler gemeldet, da der Bot nicht auf die Seite zugreifen kann.

So behebst du 401-Fehler:

- Überprüfe die Authentifizierungseinstellungen: Wenn deine Seite einen Login der Nutzer voraussetzt, solltest du die Authentifizierungseinstellungen überprüfen und sicherzustellen, dass sie korrekt konfiguriert sind.

- Zugriff testen: Teste den Zugriff auf deine Seite manuell, indem du die URL im Browser eingibst. Bei passwortgeschützten Seiten wird man hier oft auf die Login-Seite weitergeleitet. Oder aber du nutzt die Live-Vorschau in der Google Search Console. Gib dazu die gewünschte URL oben in der Suchleiste ein, drücke Enter auf deiner Tastatur und wähle anschließend LIVE-URL TESTEN oben rechts (s. nächster Screenshot „Live URL testen“).

- Überprüfe die Zugriffsbeschränkungen: In deinem Dashboard beim Hosting-Anbieter hast du (in der Regel) die Möglichkeit, bestimmte IP-Adressen zu blockieren, sodass diese nicht auf deine Website zugreifen können. Überprüfe, ob du nicht versehentlich die IP-Adresse des Googlebots blockiert hast. Eine Übersicht über die IP-Adressen des Googlebots findest du hier bei SISTRIX.

- Überprüfe Zugriffe durch User Agents: In deiner robots.txt kannst du verschiedenen User Agents (auch derer von Suchmaschinen) Zugriff auf deine Seite gebieten oder verwehren. Wenn du möchtest, dass deine Seite vom Googlebot gecrawlt wird, solltest du sicherstellen, dass der Zugriff des Google User Agents erlaubt wird.

Google Search Console – Live URL testen

Nachdem du das 401-Problem identifiziert und gelöst hast, solltest du einen erneuten Crawl der entsprechenden Seite(n) anfordern. Dazu gibst du die URL in der GSC oben in die Suchleiste ein, drückst Enter und klickst anschließend auf Indexierung beantragen.

Google Search Console – Indexierung einer URL beantragen

Soft 404-Fehler

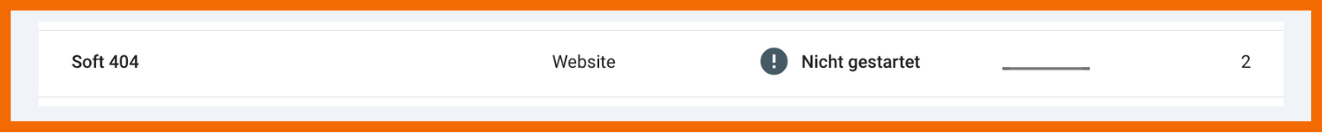

Google Search Console – Soft 404

Soft 404-Fehler entstehen, wenn eine Seite den Statuscode 200 (= “alles okay“) zurückgibt, andere Signale auf der Seite aber darauf hindeuten, dass hier gar keine Seite existiert. Diese Diskrepanz kann den Googlebot und auch User:innen verwirren. Klingt zu abstrakt?

Hier findest du häufige Szenarien, die zu einem Soft 404 führen:

- Leere Seiten: Seiten ohne oder mit nur sehr wenig Inhalt führen oft zu einem Soft 404-Fehler. Obwohl der Server einen „200 OK“-Statuscode zurückgibt, deutet der fehlende Inhalt darauf hin, dass die Seite den Nutzern keine sinnvollen Informationen liefert.

- Weitergeleitete Seiten: Wenn eine Seite auf eine andere URL umgeleitet wird, aber der Inhalt der Ziel-URL dünn oder nicht relevant ist, könnte Google dies als Soft-404-Fehler interpretieren.

- Benutzerdefinierte Fehlerseiten: Wenn deine Website eine benutzerdefinierte Fehlerseite hat, die Nutzerinnen und Nutzern eine Fehlermeldung anzeigt, obwohl sie einen „200 OK“-Statuscode hat, kann dies ebenfalls einen Soft-404-Fehler auslösen.

So behebst du Soft 404-Fehler:

- Inhalt überprüfen: Sieh dir den Inhalt der Seite an, die den Soft 404 produziert hat. Ist er sehr dünn oder ist gar kein Inhalt vorhanden, solltest du den Inhalt entweder verbessern, oder die Seite auf eine relevantere URL umleiten.

- Weiterleitungen überprüfen: Wenn die betroffene URL bereits weitergeleitet wird, musst du dir die Zielseite ansehen. Wenn diese dünne oder keine Inhalte aufweist, solltest du die ursprüngliche URL besser auf eine andere Seite umleiten. Auch die Seite, auf die ursprünglich umgeleitet wurde, solltest du auf eine andere Seite umleiten. Achte darauf, keine Weiterleitungsschleifen zu produzieren, sondern Seiten direkt weiterzuleiten.

- Fehlerseiten überprüfen: Wenn du benutzerdefinierte Fehlerseiten auf deiner Website verwendest, solltest du sicherstellen, dass auch diese Seiten relevante Informationen enthalten. Ansonsten werden sie als leere bzw. irrelevante Seiten angesehen und führen möglicherweise zu einem Soft 404. Wie du nützliche und ansprechende 404-Seiten gestaltest, findest du hier.

Redirect-Fehler

Weiterleitungen führen User:innen und Crawler automatisch von einer URL zu einer anderen. Wenn du beispielsweise eine Seite löschst, solltest du deren URL auf eine Seite weiterleiten, die existiert. Wenn du bemerkst, dass du zwei Seiten mit identischem oder sehr ähnlichem Inhalt hast, solltest du ebenfalls eine Weiterleitung von der einen auf die andere URL einrichten.

Redirect-Fehler treten dann auf, wenn diese Umleitung aus verschiedenen Gründen nicht funktioniert. Diese Fehler können dazu führen, dass Crawler deine Seite nicht mehr ordentlich crawlen, indexieren und verarbeiten können.

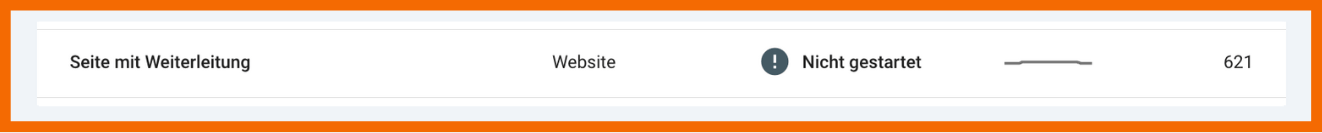

Google Search Console – Redirect-Fehler

Häufige Umleitungsfehler sind:

- Weiterleitungsketten: Wenn du eine URL auf eine andere URL umleitest, diese wiederum auf eine dritte URL und diese auf eine vierte usw., dann entsteht eine Weiterleitungskette. Diese kann die Ladezeit deiner Seite verlangsamen und sich negativ auf die Nutzerfreundlichkeit und das Crawling auswirken.

- Umleitungsschleifen: Wenn du die letzte URL einer Weiterleitungskette wieder auf eine vorherige URL in der Kette zurückleitest, entsteht eine Art Endlosschleife. Diese kann sowohl das Laden als auch das Crawling einer Seite verhindern.

- Schlechte Weiterleitungen: Wenn du eine Seite zu einer fehlerhaften oder irrelevanten URL weiterleitest, kann dies zu einem Fehler führen.

So behebst du Weiterleitungsfehler:

Um alle Seiten mit Weiterleitungsfehlern zu identifizieren, klickst du in der Google Search Console unter Indexierung auf Seiten und scrollst anschließend runter zum Bericht „Warum Seiten nicht indexiert werden“. Dort klickst du auf den Fehler Seite mit Weiterleitung, um alle URLs aufzurufen, die einen Redirect-Fehler aufweisen.

- Weiterleitungsketten auflösen: Wenn du Weiterleitungsketten identifizierst, musst du diese auflösen. Leite am besten von allen Seiten direkt auf die letzte Ziel-URL weiter.

- Umleitungsschleifen auflösen: Wenn du Umleitungsschleifen entdeckst, ermittelst du zunächst die Quelle der Schleife. Dann gehst du wie bei der Weiterleitungskette vor und leitest alle URLs in der Schleife direkt auf eine relevante Ziel-URL um. Stelle sicher, dass die Ziel-URL nicht nochmal auf eine andere Seite weitergeleitet wird.

- Weiterleitungsziele überprüfen: Überprüfe, ob alle Ziel-URLs relevant und aufgesetzt sind. Falsche Weiterleitungen können Benutzer:innen und Suchmaschinen verwirren.

- Interne Links aktualisieren: Wenn du URLs geändert und weitergeleitet hast, die auf einer anderen Seite verlinkt sind, solltest du diese Verlinkungen bearbeiten. Statt der weitergeleiteten Seite setzt du direkt die Ziel-URL ein. So wird die Notwendigkeit von Weiterleitungen und damit die Fehleranfälligkeit verringert.

- Richtige Statuscodes verwenden: Stelle sicher, dass du die richtige Art von Weiterleitung wählst. In der Regel haben Umleitungen den Statuscode 301 (permanente Weiterleitung). Eine temporäre Weiterleitung (302) macht nur selten Sinn, etwa bei einem Relaunch.

Probleme mit Crawling und Indexing

Crawl- und Indexierungsprobleme treten auf, wenn die Crawler von Google eine Seite nicht erreichen können, die sie eigentlich erreichen sollten. Oder wenn sie daran gehindert werden, eine Seite in ihren Index aufzunehmen.

Dieses Problem kannst du ebenfalls im Reiter Seiten in der Google Search Console überprüfen.

Die folgenden Probleme können auftreten:

Blockiert durch Robots.txt

Über die Robots.txt kannst du spezifische Seiten, Verzeichnisse oder die komplette Website blockieren und so verhindern, dass der Googlebot die Seite crawlt und indexiert. Wenn das absichtlich geschieht, ist alles in Ordnung. Wenn der Googlebot aber unabsichtlich ausgeschlossen wird, kann das zu einem Problem führen.

Google Search Console – durch robots.txt-Datei blockiert

Die Robots.txt ist eine Datei, die sich auf deiner Website befindet und Anweisungen für Suchmaschinen-Crawler enthält. Es ist normalerweise die erste Seite, die sie auf deiner Website besuchen.

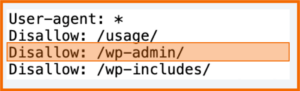

Mit der „disallow“-Anweisung kannst du Crawlern mitteilen, welche Seiten nicht gecrawlt werden sollen. Das macht beispielsweise bei Verwaltungsseiten Sinn, die ohne Anmeldung nicht zugänglich sind. Dabei kann sich die Anweisung auf einzelne Seiten, auf Verzeichnisse oder die ganze Website beziehen.

Im Screenshot siehst du, wie der Admin-Bereich einer WordPress-Website vom Crawling und damit dem Indexing ausgeschlossen wird.

robots.txt – Ausschluss aller User-Agents vom WordPress-Admin-Bereich

Wenn es gewollt ist, dass bestimmte URLs oder Verzeichnisse ausgeschlossen werden, liegt hier kein Problem vor. Nur wenn URLs fälschlicherweise ausgeschlossen werden, solltest du tätig werden und dem Problem auf den Grund gehen.

So behebst du Fehler in der robots.txt

Zunächst identifizierst du die Seiten, welche fälschlicherweise durch die robots.txt blockiert werden. Dazu gehst du in der GSC auf Seiten und klickst in der Liste „Warum Seiten nicht indexiert werden“ auf Durch robots.txt-Datei blockiert. Anschließend siehst du alle URLs, die durch die robots.txt ausgeschlossen werden. Diese Liste gehst du nun Schritt für Schritt durch und identifizierst die Seiten, die nicht blockiert werden sollten.

Mithilfe eines robots.txt-Validators, beispielsweise dem von Technical SEO, kannst du nun herausfinden, an welcher Stelle deiner robots.txt die Seite vom Crawling ausgeschlossen wird. Anschließend kannst du die robots.txt bearbeiten und den Fehler beheben.

Wenn du ein Hostinganbieter wie Wix oder Blogger verwendest, musst du dich beim Anbieter informieren, wie du Änderungen an der robots.txt vornehmen kannst. In der Regel musst du die Änderung dann beim Anbieter einreichen und sie nehmen die Aktualisierung der robots.txt-Datei für dich vor.

Falls das nicht der Fall ist, gehst du wie folgt vor:

- Rufe die robots.txt deiner Seite auf. Dazu gibst du die URL deiner Seite an und hängst /robots.txt an. Beispielsweise so: https://stage.121watt.de/robots.txt

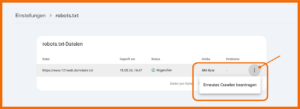

- Lade deine robots.txt-Datei mit einem Tool wie beispielsweise cURL herunter. ODER lade die Datei über die Google Search Console herunter . Du findest sie unter Einstellungen > robots.txt.

- Öffne die heruntergeladene Datei in einem Texteditor und nimm die gewünschte Änderung vor. Anschließend speicherst du die Datei wieder. Achte dabei auf die richtige Syntax und verwende beim Speichern die UTF-8-Codierung.

- Zuletzt lädst du die Datei im Stammverzeichnis deiner Website als Textdatei hoch. Dieser Vorgang ist von Hostinganbieter zu Hostinganbieter unterschiedlich und hängt stark von der Website- und Serverarchitektur deiner Seite ab. Bitte informiere dich hier bei deinem Hostinganbieter.

- Google crawlt deine Seite automatisch alle 24 Stunden, was bedeutet, dass die Änderung spätestens nach 24 Stunden in Kraft tritt. Möchtest du, dass die Seite schneller gecrawlt wird, kannst du in der GSC unter Einstellungen > robots.txt das Crawling direkt neu beantragen.

Google Search Console – robots.txt bearbeiten und neu einreichen

Probleme mit der Benutzerfreundlichkeit

Website-Probleme, die sich negativ auf die Nutzerfreundlichkeit deiner Website auswirken,

und eine schlechte Benutzererfahrung verursachen, sind aus zwei Gründen kritisch:

- Eine schlechte Nutzererfahrung führt zu Misstrauen gegenüber deinem Unternehmen. Bietest du den Nutzerinnen und Nutzern keine gute Nutzererfahrung, werden sie deine Website wahrscheinlich kein zweites Mal besuchen.

- Positive Nutzererfahrungen sind ein wichtiger Rankingfaktor für Google. Seiten mit schlechter Nutzerfreundlichkeit schneiden in den Suchergebnissen in der Regel schlecht ab.

Core Web Vitals

Core Web Vitals sind von Google festgelegte Metriken, die die Ladeleistung, Interaktivität und visuelle Stabilität einer Seite messen. Sie geben Aufschluss über die Nutzerfreundlichkeit deiner Seite und messen, wie schnell und angenehm die Nutzung deiner Seite ist.

Die drei wichtigsten Metriken sind:

- Largest Contentful Paint (LCP): Gibt die (durchschnittliche) Zeit an, die benötigt wird, bis das größte Inhaltselement (etwa eine Grafik oder ein Textblock) auf dem Bildschirm der Nutzenden sichtbar wird.

- Interaction to Next Paint (INP): Misst, wie schnell die Website auf Nutzerinteraktionen reagiert.

- Kumulative Layout-Verschiebung (CLS): Misst, wie oft die Website durch das Laden der verschiedenen Objekte verschoben wird.

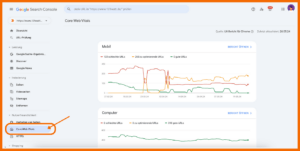

Informationen zu den Leistungsdaten deiner Website findest du in der Google Search Console im Reiter Nutzerfreundlichkeit > Core Web Vitals.

Google Search Console – Core Web Vitals

Behebe Probleme bei den Core Web Vitals:

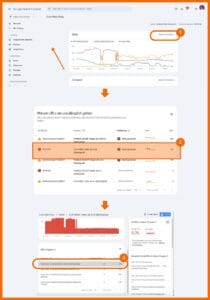

Um herauszufinden, was das Problem bei den URLs ist, die im Core Web Vitals-Bericht mit „schlecht“ gekennzeichnet sind, klickst du zunächst auf Bericht öffnen. Du hast dabei die Wahl, die mobile oder die Desktop-Seite zu wählen. Wir würden empfehlen, den Fokus auf die mobile Seite zu legen, da Google zur Bewertung deiner Seite die mobile Version verwendet.

Scrollst du dann nach unten, erhältst du einen Bericht über die verschiedenen CWV-Probleme, die auf deiner Website auftreten. Wenn du auf eines der Probleme klickst, öffnet sich eine weitere Berichtsebene mit konkreten URLs bzw. URL-Gruppen, die verbessert werden sollten. Klickst du hier auf eine der Beispiel-URLs, öffnet sich auf der rechten Seite ein Fenster, in welchem weitere Informationen und URLs angezeigt werden.

Google Search Console – Probleme mit den Core Web Vitals identifizieren

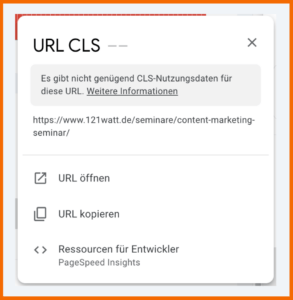

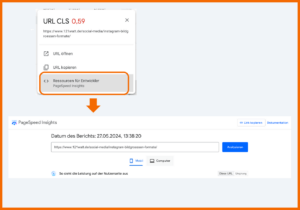

Zugegeben: An dieser Stelle kommst du in der Google Search Console leider oft nicht weiter. Oftmals wird ein Problem bei den Core Web Vitals auch damit beschrieben, dass nicht genügend Daten zur Auswertung vorliegen.

Google Search Console – nicht genügend Daten für die Auswertung der Core Web Vitals

Aber auch, wenn tatsächlich ein Problem vorliegt, ist hier erstmal Ende. Wenn du Problemen weiter auf den Grund gehen willst, musst du die PageSpeed Insights von Google aufrufen. Praktischerweise sind sie direkt aus der GSC ansteuerbar. Klickst du auf Ressourcen für Entwickler, wirst du direkt zu den PageSpeed Insights weitergeleitet und Google fügt sogar die URL ein, welche du zuvor in der Google Search Console ausgewählt hast.

Google Search Console – direkte Anbindung zu den PageSpeed Insights

Bei den PageSpeed Insights bekommst du relevante Informationen zur Performance deiner Seite sowie umfassende Hilfestellung zum Beheben von Problemen.

HTTPS-Fehler in der Google Search Console

Um die Sicherheit deiner Website zu gewährleisten, solltest du ein SSL-Zertifikat besitzen. Dieses verschlüsselt Daten, die zwischen deiner Website und einem Browser hin- und hergeschickt werden.

Unter Nutzerfreundlichkeit > HTTPS kannst du einsehen, ob alle deine Seiten mit dem Sicherheitszertifikat ausgestattet sind. Es öffnet sich ein Bericht, in welchem angezeigt wird, wenn es Seiten gibt, die kein SSL-Zertifikat haben.

Google Search Console – HTTPS-Status

So behebst du HTTPS-Fehler

Falls du HTTPS-Fehler hast, findest du unter der Übersicht einen Bericht, welcher Aufschluss darüber gibt, warum Seiten nicht über HTTPS zur Verfügung stehen. Klickst du darauf, werden dir alle betroffenen URLs deiner Website angezeigt. Diese solltest du von deiner Website entfernen.

Manuelle Maßnahmen in der Google Search Console

Google behält es sich vor, bei Verstößen gegen ihre Richtlinien manuelle Maßnahmen zu verhängen. Diese werden von menschlichen Prüferinnen und Prüfern, die bei Google angestellt sind, verhängt. Sie sollen Websites für verschiedene Vergehen bestrafen und unterscheiden sich von automatischen Abstrafungen durch den Algorithmus.

Häufige Gründe für manuelle Maßnahmen sind:

- Unnatürliches Linkbuilding: Unlautere Praktiken von Link-Building werden von Google abgestraft. Dazu zählen der Kauf und Verkauf von Links, Linktausch, Link Farming, der Einsatz von automatischen Link-Building Softwares und das Erstellen von irrelevanten Links im großen Stil.

- Dünne Inhalte: Inhalte, die den Nutzenden nur wenige oder keinen Mehrwert bieten, bezeichnen wir als “dünne Inhalte”. Sie widersprechen den Google Webmaster Guidelines.

- Doppelte Inhalte: Seiten, die gleiche oder ähnliche Inhalte beinhalten, bezeichnen wir als Duplicate Content. Dieser steht ebenfalls im Widerspruch zu den Webmaster Guidelines und kann mit einer manuellen Maßnahme bestraft werden.

- Cloaking: Bei Cloaking werden der Suchmaschine andere Inhalte auf einer URL ausgespielt, als einem herkömmlichen Browser. Das kann unbewusst oder bewusst geschehen, wird aber in beiden Fällen mit einer manuellen Maßnahme abgestraft.

- Spammige strukturierte Daten: Die falsche oder missbräuchliche Verwendung von Markup Language (schema.org) kann ebenfalls zu einer manuellen Maßnahme führen.

- Nutzergenerierter Spam: Websites, die es Nutzern erlauben, Inhalte zu erstellen (Kommentare, Foren), können mit manuellen Maßnahmen belegt werden, wenn sie es nicht schaffen, Spam effektiv zu moderieren und zu kontrollieren.

- Gehackte Inhalte: Zum Schutz der Nutzenden kann Google manuelle Maßnahmen ergreifen, wenn es den Anschein erweckt, dass eine Website gehackt wurde und schädliche Inhalte enthält.

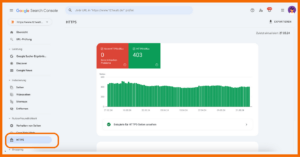

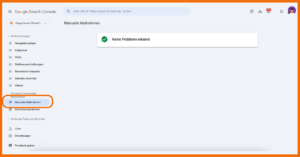

Ob dir eine manuelle Maßnahme aufgeregt wurde, erkennst du in der Google Search Console unter Sicherheit & manuelle Maßnahmen > Manuelle Maßnahmen.

Google Search Console – manuelle Maßnahmen

Falls eine manuelle Maßnahme vorliegt, findest du in diesem Reiter auch Details zum Problem. Außerdem erhältst du eine Anleitung mit Schritten, die nötig sind, um das Problem zu beheben.

Wenn du das Problem behoben hast, klickst du im Bericht auf Überprüfung anfordern. Google überprüft dann, ob das Problem gelöst wurde und wenn es nichts mehr zu beanstanden gibt, wird die manuelle Maßnahme wieder aufgehoben.

Bei Google findest du eine Liste an möglichen manuellen Maßnahmen.

Sicherheitsprobleme mit der Google Search Console identifizieren

Wenn Sicherheitsprobleme festgestellt werden, können sie sich negativ auf die Sichtbarkeit deiner Website auswirken. Zudem kann Google deine Seite als potenziell schädlich für die Nutzenden einstufen.

Die Google Search Console enthält unter „Sicherheit & manuelle Maßnahmen > Sicherheitsprobleme“ einen Bericht, in welchem potenzielle Sicherheitsprobleme auf deiner Seite aufgelistet werden.

Zu den häufigen Sicherheitsproblemen, die in der Google Search Console gemeldet werden, gehören:

- Malware Infection: Wenn Google Malware auf deiner Seite entdeckt, wird im Bericht darauf hingewiesen. Die bösartige Software könnte deinen Besucherinnen und Besuchern schaden.

- Gehackte Inhalte: Wenn deine Website gehackt wurde, spricht Google eine Warnung aus. Angreifer:innen könnten unerwünschte Inhalte oder Links einfügen.

- Social Engineering: Google erkennt, wenn deine Website in Social-Engineering-Angriffe verwickelt ist, beispielsweise Phishing oder andere betrügerische Praktiken.

So kannst du Sicherheitsprobleme beheben:

Im Abschnitt „Sicherheit & manuelle Maßnahmen“ klickst du auf Sicherheitsprobleme. Falls deine Website Probleme bei der Sicherheit aufweist, werden diese hier genannt.

Google stellt Informationen über die Art der erkannten Sicherheitsprobleme bereit. Außerdem bekommst du Empfehlungen oder Maßnahmen zur Behebung der Probleme.

Wenn Malware oder gehackte Inhalte entdeckt werden, solltest du deine Website bereinigen und sichern. Entferne jeglichen bösartigen Code, aktualisiere die Passwörter und ergreife wo möglich zusätzliche Sicherheitsmaßnahmen.

Nachdem du die Sicherheitsprobleme behoben hast, reichst du deine Seite erneut bei Google zur Überprüfung ein. Wenn die Probleme ordentlich behoben wurden, wird die Meldung im Bericht entfernt.

Wie kannst du Fehler von vornherein verhindern?

Fehler passieren, das ist normal. Allerdings kannst du einige Maßnahmen vornehmen, um Fehler so früh es geht zu identifizieren oder sie gar nicht erst entstehen zu lassen.

- In regelmäßigen Website-Audits kannst du (technische) Probleme identifizieren und sofort beheben.

- Stelle sicher, dass deine Website über eine XML-Sitemap verfügt, die alle relevanten Seiten enthält und die regelmäßig aktualisiert wird.

- Überprüfe regelmäßig deine robots.txt-Datei. Baue sie am besten übersichtlich und sinnvoll auf, damit die Aktualisierung leicht fällt und damit Google und andere Bots sie korrekt auslesen können.

- Stelle sicher, dass deine Website über ein gültiges SSL-Zertifikat verfügt, das eine sichere Verbindung (HTTPS) ermöglicht.

- Optimieren die Bilder auf deiner Website für schnelleres Laden. Verwende außerdem für jedes Element einen eindeutigen Dateinamen und füge Alt-Texte hinzu.

- Etabliere eine sinnvolle URL-Struktur. Gestalte die URLs einfach, beschreibend und nutzerfreundlich. Vermeide dabei komplexe URL-Parameter oder kryptische Buchstaben- und Zahlen-Kombinationen.

Du hast nun eine ganze Palette an Problemen kennengelernt, die du mit der GSC identifizieren kannst. Sicherlich gibt es noch weitere, die sich mithilfe der GSC aufdecken lassen, wir haben allerdings die gängigsten gesammelt.

Wie du siehst, ist es kein Hexenwerk, Probleme in der Google Search Console zu identifizieren. Um sie zu beheben, braucht es manchmal allerdings die Hilfe von Entwicklern, besonders dann, wenn es sich um technische Probleme handelt.

Aus dem Englischen von SEMrush.

Wie hilfreich ist dieser Artikel für dich?

Noch ein Schritt, damit wir besser werden können: Bitte schreibe uns, was dir am Beitrag nicht gefallen hat.

Noch ein Schritt, damit wir besser werden können: Bitte schreibe uns, was dir am Beitrag nicht gefallen hat.

Vielen Dank für dein Feedback! Es hilft uns sehr weiter.

gar nicht hilfreich

weniger hilfreich

eher hilfreich

sehr hilfreich

ich habe ein anderes Thema gesucht