Was ist eine Logfile-Analyse?

Keine Artikel mehr verpassen? Jetzt Newsletter abonnieren »

Level: Beginner

Weißt du, was auf diesem Screenshot zu sehen ist? Kannst du Informationen ableiten? Wenn nicht, bist du hier genau richtig. Der Screenshot zeigt ein sogenanntes Logfile. Wir erklären dir heute, was ein Logfile ist, wie du es analysierst und warum es wieder wichtig werden könnte. Unsere Informationen haben wir von Semrush.

Was sind Logfile und Logfile-Analyse?

Ein Logfile ist ein Dokument, in welchem jede einzelne Anfrage, die an deinen Server gestellt wird, registriert und dokumentiert wird. Sie gibt dir Informationen darüber, wie Personen, Suchmaschinen und andere Bots mit deiner Seite interagieren. Das Logfile wird auf deinem Server gespeichert. Dort kannst du es herunterladen, um eine Logfile-Analyse durchzuführen. Bei einer Logfile-Analyse auditierst du dein Logfile um Fehler, Bugs, Probleme beim Crawling oder andere technische Probleme aufzudecken.

In dem Logfile werden dabei grundlegende Daten zu den Besucher:innen und den Crawlern der Website aufgezeichnet:

- IP-Adresse & Host Name

- Herkunftsland

- Verwendeter Browser und Betriebssystem

- Ob User:innen direkt auf die Website kamen oder von anderen Seiten oder Anzeigen

- Verwendete Suchmaschine & verwendeter Suchbegriff

- Verweildauer

- Wie viele Seiten aufgerufen wurden

- Ausstiegsseite

Die Logfile Analyse kann dir helfen, technische SEO-Probleme zu identifizieren und diese zu beheben, sodass sich die SEO-Performance deiner Seite verbessert. Folgende Dinge kannst du über das Logfile herausfinden:

- Welche Seite wie oft gecrawled wird

- Höhen und Tiefen bei der Frequenz der Crawls

- Seitenladezeit für Google

- HTTP Status Codes, z. B. Redirects oder 404-Seiten

Warum könnten Logfiles wieder wichtig werden?

Um zu verstehen, warum Logfile-Analysen wieder wichtig werden können, musst du das „Gegenteil“ eines Logfiles kennen. Das sogenannte „Page Tagging“ ist eine auf JavaScript basierende Tracking-Methode, welche Logfile-Analysen beinahe vollständig abgelöst hat. Analysetools wie Google Analytics 4 oder Matomo setzen dieses Page Tagging ein, um User:innen zu tracken. Voraussetzung dafür ist, dass Cookies (= kleine JavaScripts) gesetzt werden. Die zunehmende Bedeutung und das stärkere Bewusstsein über Datenschutz, Privatsphäre und personenbezogene Daten erschweren das Tracking mit Cookies. In Zukunft ist es sogar denkbar, dass das Tracking mit Cookies per Gesetz komplett verboten wird. Darüber können wir nur spekulieren. In diesem Fall könnte die Logfile-Analyse einen Teil dieser Analysen ersetzen. Der Vorteil von Logfiles gegenüber dem Tracking mit JavaScript ist beispielsweise, dass auch Zugriffe von User:innen registriert werden, die Cookies ablehnen oder die Adblocker verwenden.

Auf der anderen Seite hat sich das Tracking mit JavaScript (also ein herkömmliches Analyse-Tool) nicht umsonst gegen das Tracking per Logfile-Analyse durchgesetzt. Zum einen ist das Setup und auch die Nutzung eines Analyse-Tools viel einfacher und intuitiver. Zum anderen ist JavaScript Tracking viel individueller und du kannst es ziemlich passgenau an deine Bedürfnisse anpassen.

Im Idealfall kombinierst du beide Methoden, um das meiste aus deinem Tracking rauszuholen.

Wie analysiere ich ein Logfile?

Eine manuelle Logfile-Analyse ist mühsam. Sehr mühsam. Du musst zunächst die Logfile-Datei(en) herunterladen. Anschließend sortierst du die einzelnen Einträge in eine Excel-Tabelle. Hast du das alles gemacht, kannst du beispielsweise nach bestimmten Crawlern filtern.

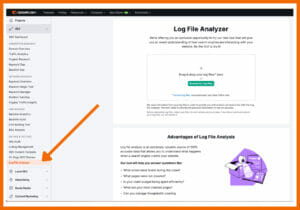

Je größer deine Seite ist, desto mehr Aufwand hast du. Ab einer bestimmten Größe macht eine manuelle Logfile Analyse keinen Sinn mehr, da du viel zu viel Zeit mit der Pflege verschwendest. Stattdessen kannst du ein Logfile-Analyse-Tool verwenden. Semrush bietet beispielsweise die integrierte Log File Analyzer. Es gibt aber auch spezielle Anwendungen wie beispielsweise Logflare.

Wir spielen das Ganze am Beispiel von Semrush durch. (Note: Wir haben nur ein sehr kleines Logfile ausgewählt, weswegen nicht allzu viele Zahlen verfügbar sind).

Bevor du startest, musst du das Logfile deiner Website herunterladen. Ein beliebtes Tool dafür ist File Zilla, ein File Transfer Protocol Client. Damit musst du eine neue Verbindung zum Server herstellen und anschließend das Logfile auf dem Server finden. Wenn du Hilfe dabei brauchst, wende dich an deine IT.

Du findest den Log File Analyzer du im Menü unter On Page & Tech SEO. Dort kannst du deine Logfile hochladen.

Anschließend bekommst du folgende Informationen ausgespielt:

Googlebot Activity

Im ersten Diagramm siehst du die Aktivitäten des Googlebot. Es zeigt tageweise, wann der Googlebot deine Website gecrawled hat. Auf der rechten Seite siehst du außerdem die Status Codes der Seiten sowie die Dateitypen, die angefragt wurden.

Hier bekommst du schon Auskunft darüber, ob es ein Problem mit dem Crawling und Indexing gibt (beispielsweise, wenn gar keine Crawls durchgeführt werden). Außerdem bekommst du so einen ersten Eindruck davon, wie viele 404-Seiten du hast.

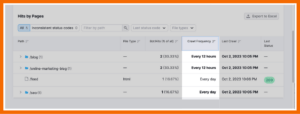

Hits by Pages

In dieser Tabelle findest du eine Übersicht über die einzelnen Ordner und Seiten deiner Tabelle. Indem du sie nach Crawl Frequency sortierst, siehst du, welche deiner Seiten am häufigsten gecrawled werden.

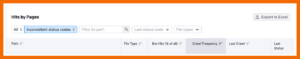

Im Reiter Inconsistent status codes kannst du dir Seiten anzeigen lassen, deren Statuscodes sich innerhalb des analysierten Zeitraums geändert haben.

Übersetzt aus dem Englischen von Semrush. Dort findest du auch weitere Informationen darüber, wie du die Crawlability deiner Seite sicherstellst.

Wie hilfreich ist dieser Artikel für dich?

Noch ein Schritt, damit wir besser werden können: Bitte schreibe uns, was dir am Beitrag nicht gefallen hat.

Noch ein Schritt, damit wir besser werden können: Bitte schreibe uns, was dir am Beitrag nicht gefallen hat.

Vielen Dank für dein Feedback! Es hilft uns sehr weiter.

gar nicht hilfreich

weniger hilfreich

eher hilfreich

sehr hilfreich

ich habe ein anderes Thema gesucht